2012-2016 : consolidation publicitaire et intégration médiatique

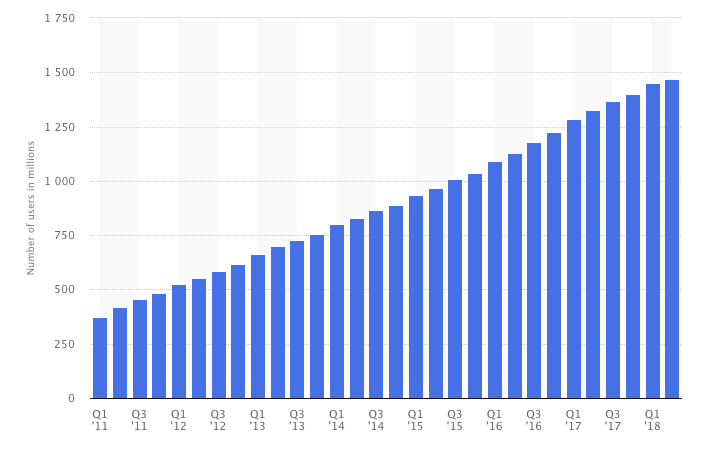

2012 est une année charnière pour Facebook. D’une part, l’explosion de l’usage de smartphones lui offre un champ de développement sans précédent. D’autre part, son introduction en Bourse accentue la pression des investisseurs et des observateurs sur ses performances économiques. Si Facebook est à l’équilibre depuis le deuxième trimestre de 2009, le taux de monétisation de son offre publicitaire avant 2012 reste faible. C’est surtout l’augmentation exponentielle du nombre d’utilisateurs qui augmente les revenus publicitaires et permet à la société d’être rentable.

Comme l’explique dans un livre qui fit sensation, Antonio Garcia Martinez, qui a été l’un des artisans de la mise en place de l’offre publicitaire de Facebook, son principal problème à l’époque consiste à réussir à articuler les données qu’il collecte au sein de son propre périmètre avec des informations sur les habitudes de navigation et de consommation des utilisateurs à l’extérieur. La question qui en découle, et qui fait l’objet d’intenses débats en interne, est le degré d’intégration que le service peut se permettre avec ses partenaires de l’industrie publicitaire, notamment au niveau du partage des données collectées auprès des utilisateurs. C’est la même problématique de plateformisation à double logique mentionnée précédemment mais concernant cette fois-ci le nerf de la guerre : le revenu publicitaire. Plusieurs échecs ponctuent cette période, comme

le lancement de Beacon en 2007 qui créé une grosse polémique en raison de son caractère particulièrement intrusif, ce qui aboutit à sa fermeture en 2009.

L’évolution de la valorisation boursière de Facebook entre 2013 et 2018 (Source : Ycharts)

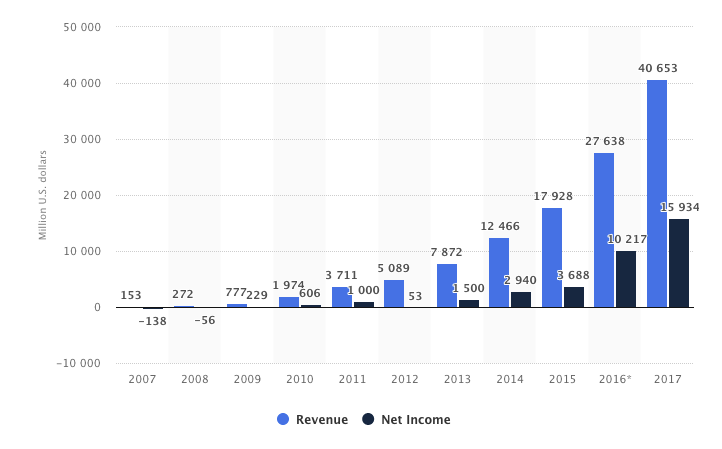

L’évolution du chiffre d’affaires et des profits de Facebook entre 2007 et 2017 (Source : Statista)

Pour répondre aux exigences des investisseurs, des efforts significatifs sont déployés par Facebook, sous la houlette de Sheryl Sandberg, pour améliorer sa monétisation, parfois au détriment de ses partenaires et utilisateurs. Par exemple, à partir de 2012, une fois les Pagesdevenues un standard populaire, Facebook commence à diminuer ce qu’il appelle organic reach, c’est-à-dire le pourcentage de « fans » effectivement touchés par les publications d’une page à laquelle ils sont abonnés. De 100 % avant 2012 ce pourcentage a baissé à 16 %, puis à 6,5 % en 2014 et jusqu’à 2 % pour les pages les plus populaires. La seule solution pour accroître ce ratio est désormais de payer Facebook. Les explications que ce dernier donne pour cette évolution font appel, comme toujours, à la supposée amélioration de l’« expérience utilisateur» à travers la hiérarchisation et la sélection algorithmique du contenu qui apparaît sur son News Feed saturé au fur et à mesure que les statuts des « amis » et les publications des Pages « likés » s’accumulent.

Néanmoins, l’objectif économique de cette nouvelle politique est évident. Elle fait partie d’une stratégie publicitaire centrale pour Facebook, à savoir le développement des formats « natifs », comme les posts sponsorisés. La publicité « native » est l’un des segments de ce marché qui croît le plus vite, car son efficacité est réputée supérieure en termes de retour sur investissement. En effet, en jouant sur la confusion entre publicité et contenu éditorial, les annonceurs ont plus de chances que leur promotion soit vue et retenue par l’internaute.

Cet effort pour accroître l’efficacité publicitaire pousse Facebook à racheter Atlas en 2013, la deuxième plus grande régie publicitaire au monde après DoubleClick. Les dispositifs de traçage utilisés par Atlas, ainsi que la prolifération des boutons Like et Share, permettent aujourd’hui à Facebook de pratiquer de manière intensive le retargeting, c’est-à-dire d’afficher des publicités auprès de ses utilisateurs en fonction des sites qu’ils ont visités par le passé. En 2013 également, Facebook met en place un partenariat avec quatre des plus gros courtiers de données étatsuniens, Datalogix, Epsilon, BlueKai et Acxiom, qui détiennent notamment des immenses bases de données sur les transactions par carte bancaire, les cartes de fidélité, etc. L’objectif est de pouvoir croiser leurs données avec les informations dont Facebook dispose sur les profils sociodémographiques et les préférences de ses utilisateurs actifs et peaufiner, ainsi, le ciblage publicitaire. L’ensemble des données produites par les dispositifs de traçage externes (Atlas, widgets, partenaires) et internes est fusionné sous un identifiant unique appelé Facebook ID.

Facebook est donc capable de proposer une « vision holistique » aux annonceurs, allant du traçage des internautes — à l’intérieur mais aussi à l’extérieur de son périmètre et sur plusieurs appareils — au ciblage publicitaire le plus fin possible et jusqu’à l’enregistrement de l’acte d’achat. En disposant de ce continuum informationnel des trois étapes cruciales (traçage, ciblage, achat), Facebook peut se targuer de mesurer assez précisément le retour sur investissement publicitaire, ce qui constitue un enjeu majeur pour les annonceurs.

Évidemment, cette concentration sans précédent de données personnelles sur des centaines de millions de personnes dans le monde entre les mains d’une seule société pose des graves risques, qui éclatent au grand jour en juin 2013 grâce aux révélations d'

Edward Snowden. Les documents que ce dernier communique aux journalistes Glenn Greenwald et Laura Poitras exposent aux yeux de l’opinion mondiale la plus grande opération d’écoute et de surveillance de masse dans l’histoire de l’humanité. Facebook, aux serveurs duquel la

NSA (National Security Agency) peut accéder à n’importe quel moment, se trouve au cœur de ce vaste dispositif d’espionnage.

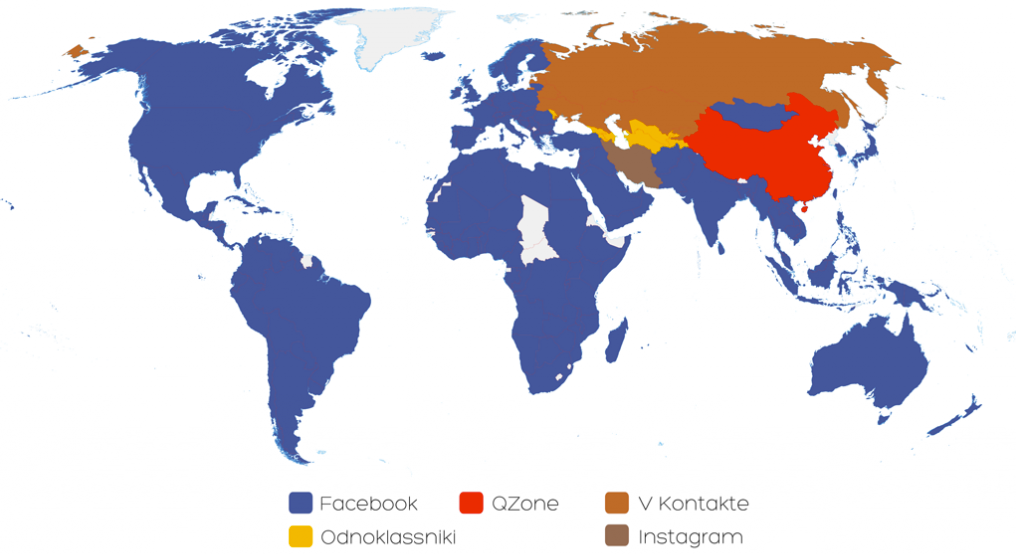

L’affaire Snowden ne va pourtant pas freiner le développement de la société. Fort d’une capitalisation gigantesque, qui atteint son record en juillet 2018 à 629 milliards de dollars, Facebook opère ainsi une intégration horizontale en rachetant des services populaires comme Instagram, en avril 2012, pour un milliard de dollars et WhatsApp en février 2014 pour dix-neuf milliards. Dans le même temps, Facebook devient progressivement la première source de trafic pour les sites d’information, dépassant pour la première fois Google en mai 2012. Cette tendance pousse les éditeurs de sites à adapter leur stratégie afin de bénéficier de cet effet d’aubaine, accentué par les nouveaux formats comme Instant Articles et le Livevidéo lancés respectivement en 2015 et 2016.

Cette centralité acquise par Facebook dans l’espace public numérique n’est pas accompagnée d’une prise de conscience des responsabilités politiques du service vis à vis de la diffusion des discours haineux, de la manipulation et de la propagande

Cependant, cette centralité acquise par Facebook dans l’espace public numérique n’est pas accompagnée d’une prise de conscience des responsabilités politiques du service vis à vis de la diffusion des discours haineux, de la manipulation et de la propagande. En, effet, à partir de 2015 le contexte politique change radicalement : les attaques terroristes et la crise migratoire notamment renforcent l’extrême droite aux États-Unis, avec l’émergence de l’Alt-Right, comme en Europe. Ces courants xénophobes et populistes n’hésitent pas à user des méthodes sophistiquées de désinformation pour influencer l’opinion publique. Les élections présidentielles aux États-Unis et le referendum sur le Brexit, en 2016, révéleront l’ampleur du problème.