Internet ne va pas de soi. C’est, au fond, ce que Sarah T. Roberts a voulu mettre en évidence en enquêtant pendant huit ans sur les « nettoyeurs du web ». Chercheuse et enseignante en sciences de l’information à l’université de Californie à Los Angeles (UCLA), elle a rencontré des dizaines de modérateurs. Chargés de faire le tri entre ce qui est jugé montrable ou non par les plateformes, ils visionnent chaque jour, au péril de leur santé psychique, ce que l’humanité produit de plus sombre.

Le fruit de son enquête, Derrière les écrans (La Découverte), vient d’être traduit en français. Sarah T. Roberts y écrit sa conviction que « toute discussion sur la nature de l’Internet contemporain est fondamentalement incomplète si elle n’aborde pas les processus par lesquels certains contenus créés par les utilisateurs sont autorisés à rester visibles quand d’autres sont supprimés, autrement dit si l’on ne se demande pas qui prend ces décisions, comment elles sont prises, et au profit de qui ».

En décrivant le travail des petites mains qui modèrent les contenus que nous postons en ligne, Sarah T. Roberts a rendu visibles des travailleurs dont l’existence a longtemps été niée par les géants du web. Elle a aussi mis au jour les mécanismes de contrôle qui façonnent l’Internet que nous connaissons et déterminent les contours de la liberté d’expression dans notre espace public numérique. Entretien.

Qui sont les modérateurs du web ?

Sarah T. Roberts : Les modérateurs de contenu se trouvent un peu partout dans le monde — aux États-Unis, aux Philippines, en Irlande, en Espagne, en Malaisie... Leur âge varie et les deux sexes semblent représentés de manière plutôt égale. Il est difficile de répondre plus précisément à cette question car les entreprises qui ont recours à leurs services exigent un secret total, tant de leurs employés directs que de leurs sous-traitants. J’estime à plus de 100 000 le nombre de personnes qui travaillent au quotidien comme modérateurs. C’est une estimation très prudente. Facebook et Google/Alphabet et leurs filiales (YouTube par exemple) comptent à elles seules des dizaines de milliers de personnes assignées à ce travail. Les « modos » sont légion.

En quoi consiste leur travail ?

Sarah T. Roberts : Il ne se limite pas au tri de vidéos. Les modérateurs sont chargés d’examiner et de valider la publication de textes, d'images fixes telles que des photos et des œuvres d'art, ainsi que des images animées, de l'audio... Chacun d’entre eux doit analyser plusieurs milliers de contenus par jour. Ce volume est d’abord dû à l’ampleur même des réseaux sociaux ; Facebook compte des milliards d’utilisateurs, qui téléchargent ou créent du contenu à un rythme effréné. C’est aussi la conséquence d’une logique de productivité : pour décrocher des contrats, les sous-traitants des plateformes qui assurent la modération bradent leurs tarifs et accroissent sans cesse la quantité de contenus qui doivent être traités en un temps donné. Invariablement, quel que soit l’endroit où est réalisé ce travail dans le monde, le salaire et le statut qu’il offre sont relativement bas. On est loin du glamour qui nimbe, dans l’imaginaire collectif, les entreprises de la Silicon Valley.

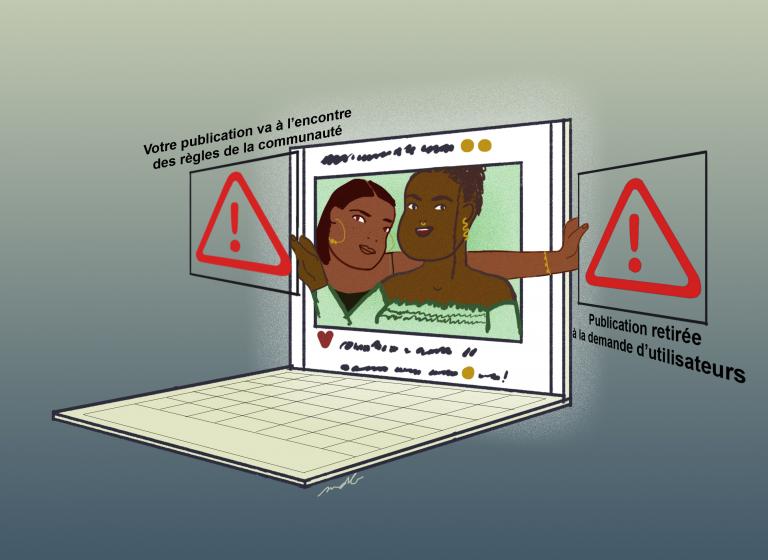

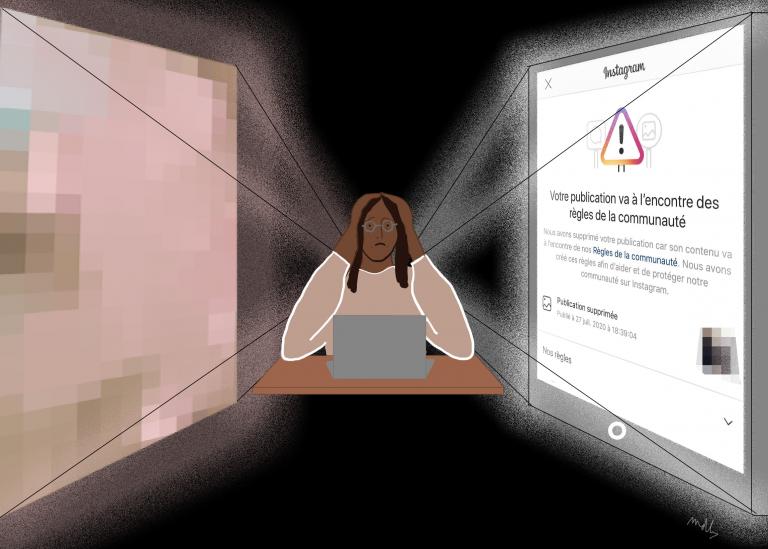

Illustration : Margot de Balasy.

Avec ce livre, vous souhaitez « mettre un terme à l’invisibilité de ces travailleurs ». Pourquoi sont-ils restés invisibles si longtemps ?

Sarah T. Roberts : Cela vient en grande partie de la décision des entreprises de réseaux sociaux, principalement américaines, de construire leurs plateformes et de solliciter l'engagement des utilisateurs sur la base d’un fantasme de libre expression totale. Et aussi d'une adhésion au cyberlibertarisme, qui considère que la meilleure approche en toute chose est d'interférer le moins possible dans le discours d’autrui. La vérité est très différente.

Quelle est-elle ?

Sarah T. Roberts : La promesse de liberté d'expression totale est un mensonge, sinon ces milliers de travailleurs qui opèrent dans l'espace invisible situé entre les internautes et ce qu’ils postent ne seraient pas nécessaires. Reconnaître leur existence, c’est aussi reconnaître que les réseaux sociaux hébergent les pires immondices dont sont capables des humains, d’où la nécessité d’obliger d’autres êtres humains à les examiner du matin au soir…

Au fond, pourquoi juge-t-on nécessaire de cacher une si grande partie de ce que publient les internautes ?

Sarah T. Roberts : Comme le dit une personne interrogée dans mon livre : « Si vous ouvrez une brèche sur Internet, il se remplit de merde. » Sans modération, les plateformes de réseaux sociaux seraient de véritables cloaques. Ce serait invivable. Ceci dit, il est important de garder à l'esprit que la modération est toujours pratiquée au profit des entreprises de réseaux sociaux — que ce soit pour maintenir de bonnes relations avec leurs annonceurs (leurs véritables clients), pour pénétrer un nouveau marché, pour se conformer aux lois ou aux normes locales, ou éviter d’avoir à gérer un désastre en matière de relations publiques.

Au début d’Internet, des utilisateurs assuraient eux-mêmes les tâches de modération...

Sarah T. Roberts : Ce modèle, bien qu'il puisse sembler appartenir au passé, existe encore dans de très nombreuses parties de l'Internet. Wikipédia et Reddit sont deux exemples clés de modération volontaire basée sur l'utilisateur. Ces modèles sont loin d'être parfaits, mais ils ont l'avantage d'être à la fois visibles et adaptés à leurs communautés. Internaute depuis 1993, j'ai fait l'expérience de nombreuses formes de modération bénévole, de la plus draconienne à la plus consensuelle. Je pense que nous avons oublié ces exemples du passé et que nous pensons qu'il n'y a qu'une seule voie possible. J'espère que nous pourrons collectivement faire preuve d'une plus grande imagination à l'avenir.

Le travail demandé aux modérateurs nous impose une vision du monde particulière. Comment la qualifieriez-vous ?

Sarah T. Roberts : On observe le développement d’une espèce de nouvelle colonisation, une exportation des normes et des mœurs américaines, qui vient du fait que les principales plateformes de réseaux sociaux sont originaires des États-Unis. J'irais même plus loin en disant que le cyberlibertarisme qui émane de la Silicon Valley (encore lui) est, par essence, intégré dans l'architecture, les fonctionnalités, la politique et les opérations des entreprises de médias sociaux. Et pourtant, parce que les plateformes aspirent à être globales, elles brassent du contenu provenant du monde entier, publié dans toutes les langues, et avec toutes les nuances culturelles imaginables… Un contenu souvent modéré par des personnes qui, elles-mêmes, peuvent se trouver à l’autre bout du monde. On voit là toute la fragilité du système, et combien de points de défaillance potentiels existent dans un tel contexte.

Quels sont les types de contenus les plus modérés ?

Sarah T. Roberts : Il suffit d'accéder à la page des « standards de la communauté » d'une plateforme, où sont recensés les comportements prohibés, pour se faire une idée de ce que les modérateurs de contenu voient et traitent généralement. Les contenus pédocriminels sont souvent les plus faciles à supprimer de façon automatisée. Le harcèlement est bien plus difficile à traiter.

Pourquoi ?

Sarah T. Roberts : Parce que le harcèlement a la double particularité de s’étaler dans le temps et d’être personnalisé. L’examiner nécessite donc un investissement particulier. C’est une des raisons pour lesquelles ce problème est souvent mal appréhendé. Du coup, les utilisateurs ont le sentiment que leurs plaintes pour harcèlement raciste, sexiste ou homophobe ne sont pas traitées correctement. Ajoutons à cela le fait que la main d’œuvre chargée de ces tâches peut potentiellement vivre sur un autre continent, et l’on comprend le défi quotidien que représente la compréhension des insultes raciales spécifiques à une langue. Les trolls et les insulteurs sont également doués pour modifier leurs tactiques afin d’échapper à la modération. Les discours de haine font partie des sujets les plus difficiles à traiter par les modérateurs, et pourtant ils sont constants.

Vous avez rencontré de nombreux modérateurs. Certains souffrent de stress post-traumatique. Ce trouble est-il reconnu ?

Sarah T. Roberts : Le stress post-traumatique des modérateurs de contenu est de mieux en mieux connu, en partie grâce à la défense des droits des travailleurs et aux organisations de la société civile, ainsi qu'à des universitaires comme moi. Il me semblait primordial de révéler au monde entier l’énorme coût social qu’ont à payer les personnes préposées à la modération, en raison de notre utilisation collective des technologies des réseaux sociaux et des mauvais comportements qui en découlent. Ce coût social est à mettre en regard avec les profits massifs des géants du web qui, profitant en grande partie de la législation américaine adoptée dans les années 1990, ne peuvent être condamnées pour les informations qui circulent sur leurs plateformes. Si certains efforts ont été faits pour améliorer les conditions de travail des modérateurs, leur tâche reste monstrueuse. Et nous n'avons aucune idée des dommages à long terme qu’ils subiront.

Illustration : Margot de Balasy.

Pour les préserver, certains suggèrent de recourir plus massivement à des outils de modération automatique. Est-ce souhaitable ?

Sarah T. Roberts : Le recours aux seuls outils automatisés ou informatiques pour soustraire les humains à la difficulté de ce travail est souvent la première idée avancée. Malheureusement, ces systèmes ne sont pas encore assez sophistiqués et ne peuvent pas se substituer à l'intelligence humaine et fournir toutes les garanties nécessaires. J'ajouterais qu'une telle décision pourrait avoir de nombreuses autres conséquences imprévues.

Que pourrait-il se passer ?

Sarah T. Roberts : Un algorithme trop puissant pourrait retirer des contenus qu’une personne physique jugerait raisonnable de laisser. Et puis il serait pratiquement impossible d'auditer un système informatique. Au cours de mon enquête, la seule façon de connaître les décisions qui ont été prises et leurs motivations a été de parler à des personnes impliquées dans ce travail. Or elles risquaient toutes de perdre leur emploi en discutant avec moi. Les accords de confidentialité sont stricts dans l'industrie de la modération de contenu et les travailleurs doivent accepter de ne rien divulguer de leur travail. Et pourtant, ils peuvent choisir de violer ces accords au nom d'un principe supérieur. Ce qu’un programme informatique ne peut pas faire.

Qui décide, finalement, de ce qui est visible sur le web ? Les utilisateurs, les modérateurs, les algorithmes, les États, les groupes militants qui cherchent à faire fermer des comptes en lançant des raids ?

Sarah T. Roberts : Je dirais que c’est une combinaison de tous les éléments que vous avez énumérés. Mais je suis convaincue qu’à tous les niveaux, les personnes - des utilisateurs réguliers aux régulateurs et législateurs du Parlement européen, par exemple — doivent d'abord mieux comprendre la complexité du sujet et les batailles menées par les différentes parties prenantes pour contrôler ces espaces en ligne, pour ensuite se sentir en mesure d’ouvrir un débat démocratique sur la voie à suivre. Les entreprises détiennent trop de pouvoir, ce qui leur permet de dicter la politique à suivre et de bien souvent fonctionner comme des États à part entière. C'est inquiétant et antidémocratique.

La diversité des opinions et la liberté d’expression vous semblent-elles menacées sur le web ?

Sarah T. Roberts : La liberté d'expression est menacée sur le web comme ailleurs. Je crois que la plus grande menace pour la liberté d'expression et d'opinion est le nombre croissant de gouvernements intolérants, autocratiques et totalitaires de par le monde. Nous ne pouvons pas nous attendre à ce que nos libertés soient respectées sur le web si elles sont attaquées dans la vie politique et dans notre vie quotidienne.

Les gouvernements exigent des réseaux sociaux qu’ils les aident à lutter contre le terrorisme, qu’ils empêchent la diffusion de meurtres ou de suicides en live… Peut-on faire autrement que de confier aux seules plateformes le pouvoir de modération ?

Sarah T. Roberts : Les plateformes savent agir après coup pour retirer du contenu qui, peut-être, a déjà circulé et été visionné par des millions de personnes. Mais quelles politiques pourraient-elles mettre en place pour dissuader les utilisateurs de diffuser de tels actes sur leurs plateformes ? Cela demande un peu d’imagination. Les plateformes ont passé quinze ans à répéter avec insistance qu'elles étaient les seules à pouvoir résoudre les problèmes qu'elles ont créés. Mais le fait de ne rien avoir prévu des difficultés à traiter le contenu publié devrait suffire à les discréditer : elles ne peuvent pas être juges et arbitres des solutions. Le public mérite d’autres options et d’autres possibilités d'interaction en ligne. Je pense également que nous pouvons apprendre du passé et tirer des leçons des débuts de l'Internet social que j’ai connu, ou d'autres contextes numériques non américains et non liés à l'Internet.

Par exemple ?

Sarah T. Roberts : Le Minitel ! L'histoire de ce réseau m'a fascinée lorsque j'étais adolescente. Et le Minitel m’a accompagnée lorsque je vivais sur la côte basque française au début des années 1990...

Pendant le confinement, au printemps 2020, certains modérateurs n’ont pas pu travailler et l’on a observé des pics de « fake news ». Quelles leçons les plateformes en ont-elles tiré ?

Sarah T. Roberts : Les modérateurs de contenu sont des pièces essentielles dans l’économie de ces plateformes, et pourtant, comme tant d'autres travailleurs essentiels, ils sont considérés comme jetables. Nous payons tous le prix de cette situation. Allons-nous apprendre à les valoriser davantage ?